티스토리 뷰

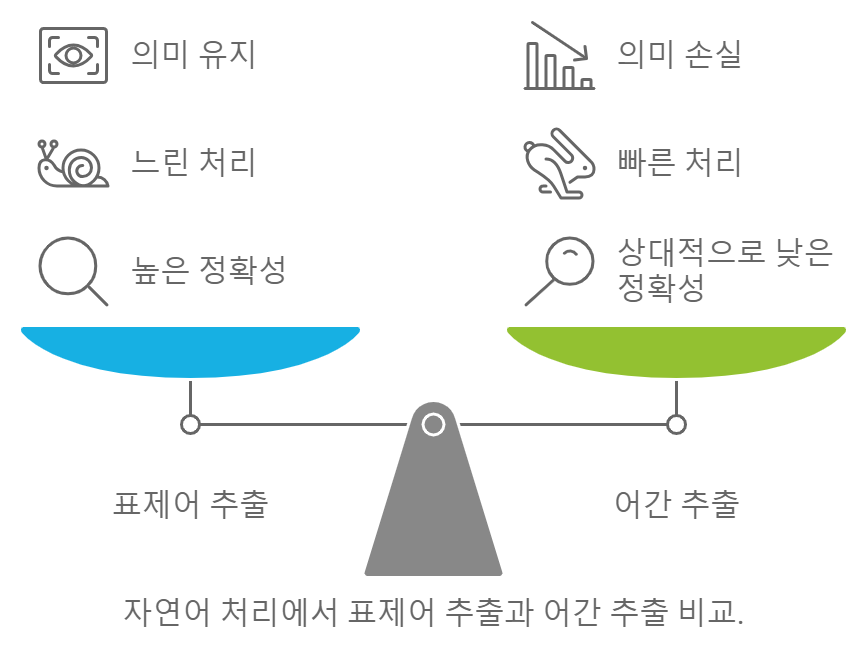

자연어 처리(NLP)에서 텍스트 데이터를 효과적으로 다루기 위해서는 전처리 과정이 필수적입니다. 이 과정에서 가장 흔히 사용되는 기법 중 두 가지가 **표제어 추출(Lemmatization)**과 **어간 추출(Stemming)**입니다. 이 글에서는 이 두 기법을 비교하여 그 차이점과 장단점을 살펴보겠습니다.

1. 정의

1.1. 표제어 추출 (Lemmatization)

표제어 추출은 단어를 그 기본 형태(표제어)로 변환하는 과정입니다. 문맥을 고려하여 단어의 의미를 유지하며, 일반적으로 사전 기반의 접근 방식을 사용합니다. 예를 들어, "running", "ran", "better"는 모두 "run"으로 변환됩니다.

1.2. 어간 추출 (Stemming)

어간 추출은 단어의 변형을 줄여 기본 형태인 "어간"으로 변환하는 과정입니다. 규칙 기반으로 단어의 끝을 잘라내어 동작하며, 문맥을 고려하지 않습니다. 예를 들어, "running", "runner", "ran"은 모두 "run"으로 변환되지만, "happiness"는 "happi"로 변환될 수 있습니다.

2. 방법론

2.1. 표제어 추출의 방법

- 사전 기반: 표제어 추출은 사전을 사용하여 단어를 분석합니다. 예를 들어, NLTK 라이브러리의 WordNetLemmatizer가 이에 해당합니다.

- 품사 태깅: 표제어 추출은 단어의 품사(명사, 동사 등)를 고려하여 변환합니다.

2.2. 어간 추출의 방법

- 규칙 기반: 어간 추출은 사전 없이 규칙에 따라 단어의 끝을 잘라내는 방식입니다. 예를 들어, NLTK의 PorterStemmer가 이 방식에 해당합니다.

- 빠른 처리: 어간 추출은 처리 속도가 빠르지만, 정확성이 떨어질 수 있습니다.

3. 장단점 비교

특성표제어 추출 (Lemmatization)어간 추출 (Stemming)

| 정확성 | 높은 정확성, 문맥을 고려 | 상대적으로 낮은 정확성, 의미 왜곡 가능 |

| 속도 | 느림 (사전 조회 필요) | 빠름 (규칙 기반) |

| 의미 유지 | 문맥과 의미를 유지 | 의미 손실 가능 |

| 용도 | 감정 분석, 문서 분류 등에서 효율적 | 검색 엔진 최적화(SEO) 등에서 유용 |

4. 실제 예제

4.1. 표제어 추출 예제

python

from nltk.stem import WordNetLemmatizer

import nltk

nltk.download('wordnet')

lemmatizer = WordNetLemmatizer()

words = ["running", "ran", "better", "children"]

lemmatized_words = [lemmatizer.lemmatize(word) for word in words]

print("표제어 추출 결과:", lemmatized_words)

출력 결과:

표제어 추출 결과: ['running', 'ran', 'better', 'children']

4.2. 어간 추출 예제

python

from nltk.stem import PorterStemmer

stemmer = PorterStemmer()

words = ["running", "ran", "better", "children"]

stemmed_words = [stemmer.stem(word) for word in words]

print("어간 추출 결과:", stemmed_words)

출력 결과:

어간 추출 결과: ['run', 'ran', 'better', 'children']

5. 결론

표제어 추출과 어간 추출은 자연어 처리에서 중요한 전처리 기법입니다. 각각의 장단점이 있으며, 사용 목적에 따라 적절한 방법을 선택하는 것이 중요합니다. 의미의 일관성을 중시하는 작업에는 표제어 추출이 더 효과적일 수 있으며, 속도가 중요한 경우에는 어간 추출이 유용할 수 있습니다. 상황에 맞는 기법을 선택하여 텍스트 데이터를 효과적으로 처리해 보세요!

'자연어 처리' 카테고리의 다른 글

| Stanford Unv. Naive Bayes 교육자료 (1) | 2024.10.20 |

|---|---|

| 나이브 베이즈와 Bag of Words (BoW) 연결하기 (4) | 2024.10.15 |

| 나이브 베이즈(Naive Bayes) 알고리즘에 대한 이해 (3) | 2024.10.15 |

| Bag of Words(BOW) 모델 이해하기 (2) | 2024.10.13 |

| [TEXT Processing] 텍스트 전처리 : Preprocessing 3단계 (4) | 2024.10.02 |

- Total

- Today

- Yesterday

- 자동매매로직

- 기술적분석

- chat gpt 가격 예상

- chat gpt api 비용 계산

- 로또 ai

- chat gpt 한국어 가격

- 토치비전

- chat gpt 모델별 예산

- 1165회 로또

- 인공지능 로또 예측

- Numpy

- 클래스형 뷰

- 오블완

- 골든크로스

- 티스토리챌린지

- 주린이탈출

- chat gpt 모델 별 가격

- 퀀트투자

- chat gpt 4o 예산

- 차트분석

- 자동매매

- 로또 1164회 당첨

- 장고 orm sql문 비교

- 1164회 로또

- 케라스

- chat gpt 모델 api 가격 예측

- 주식공부

- 재테크

- Python

- 주식투자

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |